女生地铁照片被AI一键脱衣造黄谣,全网怒了!

AI技术的发展突飞猛进,以前只能在电影中看到的画面,如今也开始陆续在现实中上演。 其背后暗藏的许多安全隐患,长期以来也一直饱受争议。 近日,国内发生的多起AI换脸、换装事件,再次将这项技术推到了舆论的漩涡中心。

本文为扩展迷原创文章,作者“okay”,未经授权请勿转载。

AI技术的发展突飞猛进,以前只能在电影中看到的画面,如今也开始陆续在现实中上演。

其背后暗藏的许多安全隐患,长期以来也一直饱受争议。

近日,国内发生的多起AI换脸、换装事件,再次将这项技术推到了舆论的漩涡中心。

3月28日,#女子地铁照被AI一键脱衣传播#冲上热搜。

据报道,广东广州一女生去年7月在小红书上发布了一张正常穿着的地铁摆拍照片。

但时隔几个月后,这张照片却被有心之人用AI软件p成了裸露照片,并发散在全网。

群聊截图显示,所谓的“爆料者”还根据这张照片编造了一段关于金主和露出的故事。

假照片一经发出,“广州地铁三号线不雅照事件”“广州地铁美女露出事件”等词条也成为了部分网友讨论的焦点。

还有人还深表遗憾,称自己没能亲自在现场围观。

很快,这张所谓的地铁裸照便被澄清为假图。

照片中的女主角实际是某红书的穿搭博主,经常发布以地铁站为背景拍摄的穿搭照片。

在原图的评论区中,已有大量网友提醒博主尽快报警,目前博主回复称正在进行相关维权处理。

如今,随着技术门槛越来越低,AI带来的隐患也越来越多。

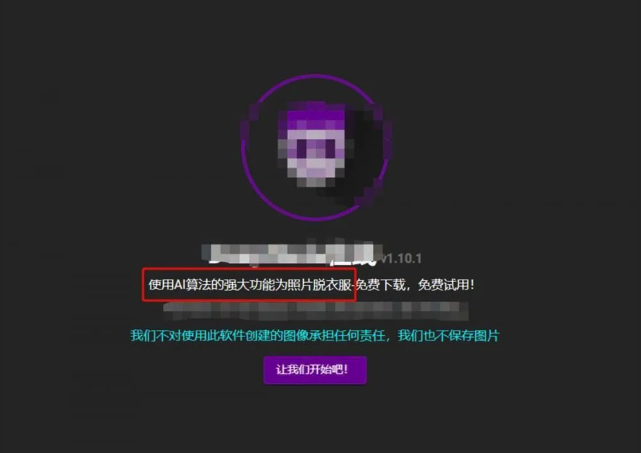

早在2019年,我们就曾报道过一款名为DeepNude的AI一键脱衣软件。

用户只需要上传一张女性照片,DeepNude就能通过AI算法用裸露的器官和皮肤替换掉人物身上的衣物。

它操作简单,处理速度非常快,用户只需点击一下,就能在30秒内获得一张“真实”色情图片。

不出意外,DeepNude一经曝光后网上便开始流传大量女星裸体的虚假照片。

该软件也迅速遭到全球舆论的抨击,没多久项目便被关闭了。

然而要想关上潘多拉的魔盒并不容易,DeepNude下架后,其源代码仍可在各种torrent网站和开放源代码存储库中找到。

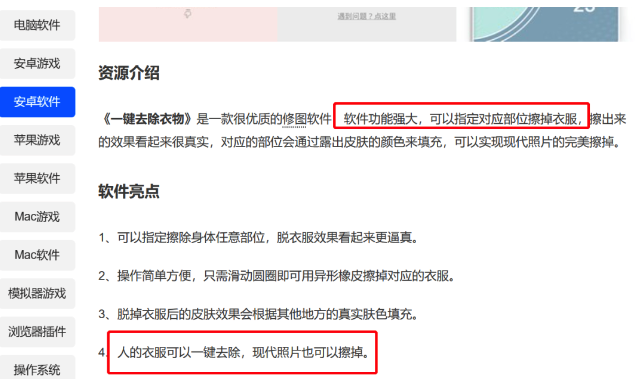

这几年里,它从未彻底消失过,甚至市面上还出现了更多的替代品。

随意在搜索引擎中查找“AI脱衣软件”,依然能搜索到众多类似功能的产品。

并且随着技术的不断优化,如今的“脱衣”程序连照片的时间、地点都能伪造得明明白白,逼真程度更胜当年。

唾手可得的脱衣软件让造谣者更加有机可乘,轻轻一点,逼真的“黄图”便轻松合成。

与之形成鲜明对比的是,受害者的维权成本极高,让不少人只能无奈放弃。

“开局一张图,其余全靠编”,已经成为了新的社会问题。

前段时间,南华大学一男生盗用女同学照片后,PS不雅图片贩卖牟利一事,掀起轩然大波。

不久前,苏州大学也开除了一名同样恶意P图造黄谣的男生,引起了广泛热议。

不仅国内,美国前总统特朗普也未能从P图造假这波“浪潮”中幸免。

这段时间来,一大批“特朗普被捕“的照片在社交平台上广泛流传。

这些照片显示,特朗普或被警察围捕、或穿着囚服、或在劳改、或在越狱,背景中还包含大量令人信服的细节。

但其实这些照片都是AI合成的,仅凭肉眼难以辨别真假。

按照我国《民法典》第一千零一十九条第一款规定,“任何组织或者个人不得以丑化、污损,或者利用信息技术手段伪造等方式侵害他人的肖像权”。

因此,未经他人同意,使用其肖像进行AI换脸并公开传播,甚至丑化、污损他人肖像的行为都构成侵权。

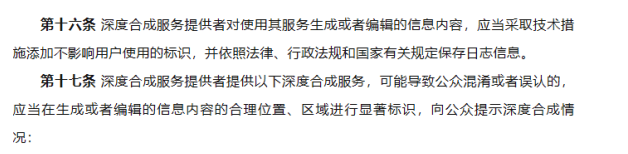

另外,国家互联网信息办公室于2022年11月25日公布的《互联网信息服务深度合成管理规定》,也对AI合成的服务提供方做出了多项规定。

比如,在提供“换脸”技术前,应该征得“被换脸”者的同意,并必须标注“这是由AI合成”之类的标识,以免误导公众。

AI技术确实降低了造谣和作假门槛,尤其是ChatGPT问世之后,AI技术产品能够以最贴近人类思维和表达的方式生成海量虚假信息。

但科技本无罪,而是那群被利益蒙了眼、脏了心的人。

技术的进步是为了造福于人类,而不是沦为动动手指就能轻易伤害他人的犯罪工具。

女生地铁照片被AI一键脱衣造黄谣,全网怒了! - Extfans”